Cómo combatir la desinformación con la inteligencia artificial híbrida

May 20, 2023 Noticias , TecnologíaLa iniciativa europea HYBRIDS, coordinada desde España, aunará el uso de redes neuronales artificiales con el conocimiento estructurado de expertos que investigarán cómo frenar las noticias falsas, la polarización de los medios, el discurso del odio o el acoso a las minorías en internet.

HYBRIDS cuenta con 11 subproyectos de investigación sobre la desinformación, con dos de ellos enfocados específicamente en las noticias falsas. / Adobe Stock

Las fake news avanzan de forma rauda y veloz, mucho más rápidamente que la información veraz y contrastada. Es una carrera contrarreloj difícil de ganar en la que la inteligencia artificial puede suponer un buen impulso.

Esto es lo que explorará en los próximos años HYBRIDS. Este proyecto europeo tratará de ahondar en técnicas de aprendizaje profundo para poner freno a los bulos y noticias falsas, el ‘hiperpartisanismo’ de algunos medios, la proliferación de los discursos de odio y el acoso a las minorías en redes sociales,

Se trata de una iniciativa internacional financiada con 2,9 millones de euros por el programa de investigación e innovación Marie Sklodowska-Curie Doctoral Networks de Horizonte Europa de la Comisión Europea. Incluye 11 subproyectos diferentes de investigación sobre la desinformación, dos de ellos dedicados a las fake news.

Su objetivo es encontrar arquitecturas y modelos que ofrezcan mayor confianza respecto a los sistemas de procesamiento natural del lenguaje basados en inteligencia artificial. La idea es generar nuevos sistemas de interpretación neurosimbólica, lo que se conoce como inteligencia híbrida.

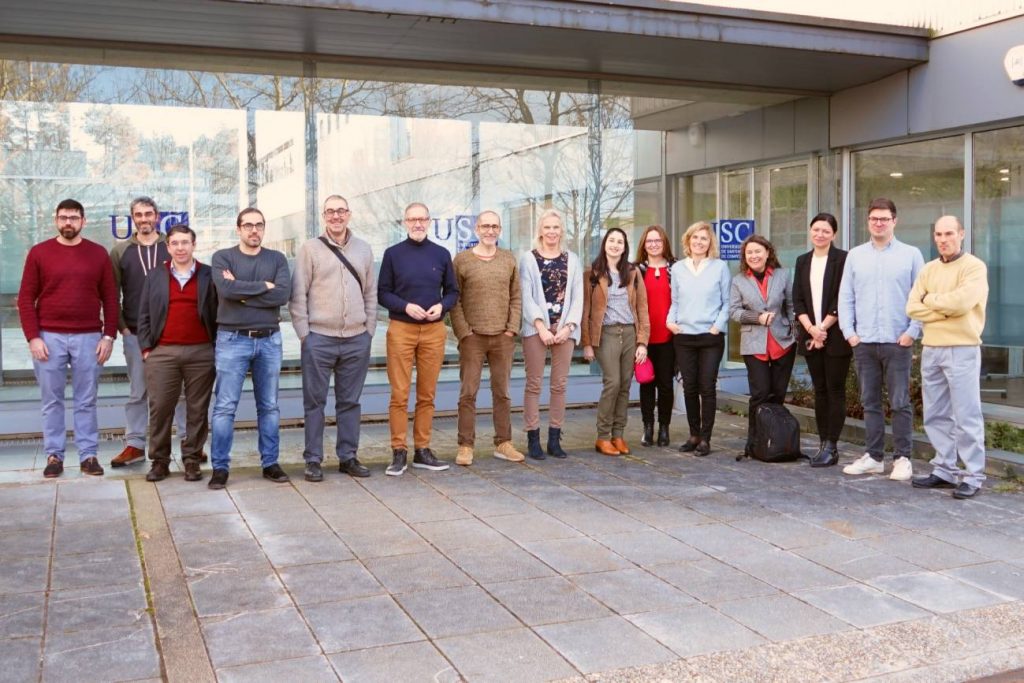

El investigador a cargo de la iniciativa frente a la desinformación es Pablo Gamallo, experto en lingüística computacional de CiTIUS

Hasta la fecha, no se han realizado demasiadas investigaciones en este campo. Desde HYBRIDS lo achacan a la dificultad para encontrar “personal de alta cualificación en estas disciplinas, tradicionalmente tan alejadas como la ingeniería informática, las ciencias sociales, la comunicación, las ciencias políticas o la lingüística”. Con esta red doctoral también se pretende contribuir a la formación de estos perfiles en metodologías híbridas.

El investigador a cargo de la iniciativa es Pablo Gamallo, experto en lingüística computacional de la institución que lidera desde España, el CiTIUS (Centro Singular de Investigación en Tecnologías Inteligentes la Universidad de Santiago de Compostela).

Además, participan en ella otros seis países europeos: Francia, Alemania, Italia, Portugal, Países Bajos y Reino Unido, incluyendo seis universidades, tres centros de investigación, dos fundaciones y tres empresas privadas. En España la empresa de fact checking Newtral forma parte del consorcio.

Controlar lo que pasa en las cajas negras de la IA

“La detección de la desinformación en sus diferentes manifestaciones es un tema muy complejo y delicado”, comenta Gamallo a SINC. “Por ello, queremos buscar métodos de inteligencia artificial que permitan la introducción de conocimiento de dominio experto y más estructurado que el humano para controlar lo que ocurre dentro de esas cajas negras, en el interior de esos sistemas de IA que son difícilmente interpretables”.

“Creemos en la hibridación también de perfiles técnicos y no técnicos. Algunos subproyectos estarán más enfocados en la creación de las herramientas y otros en la construcción de los conocimientos que se necesitan para que las herramientas funcionen bien”, añade.

La idea es usar los mejores sistemas actuales de IA introduciendo también conocimiento más estructurado o simbólico en la detección de noticas falsas

Pablo Gamallo, líder del proyecto HYBRIDS

Según aclara el investigador a cargo de HYBRIDS, los subproyectos se centrarán exclusivamente en medios de comunicación escritos y redes sociales basadas en texto. No está previsto ninguno que trabaje con vídeos o con audios.

Pablo Gamallo, investigador que capitanea HYBRIDS, en el centro de la imagen, rodeado con su equipo del CITIUS. / Foto cedida por el investigador

Las barreras de la inteligencia híbrida

Gamallo asegura que en este momento el ‘estado del arte’ de la inteligencia artificial se conformaría, sobre todo, por sistemas que aprenden a partir de muchos datos, pero con “mucha fuerza bruta”, redes neuronales de alta complejidad.

Sin embargo, “la idea es usar los mejores sistemas actuales introduciendo también conocimiento más estructurado o simbólico. Es decir, puede ser necesario conocer cuáles son los hechos verdaderos en cada dominio, saber cuáles son los argumentos y las premisas para detectar si algo es veraz. Juntando esos dos sistemas, el neuronal y el estructurado [o deep learning] llegamos a los ‘métodos neurosimbólicos‘, que son bastante emergentes y de los que hay poco publicado”, asegura el lingüística computacional.

La estructuración de los datos tampoco resulta una tarea fácil o inamovible. Cada temática tiene sus particularidades. En primer lugar, es necesario “distinguir entre lo que es un hecho factual y es opinión. Vas a los datos que son considerados por expertos como veraces. Hay que encontrar cuáles son las premisas de las que se parten para que una argumentación resulte correcta”, insiste Gamallo. “También se puede investigar en cuestiones de discurso más ligadas con la coherencia o la cohesión”.

Si ya para un humano distinguir entre hechos factuales y opiniones resulta complejo, aun puede resultarle más difícil a una máquina

El investigador reconoce que, si ya para un humano distinguir entre hechos factuales y opiniones resulta complejo, aun puede resultarle más difícil a una máquina. Solo ya la definición de lo que es ‘cierto’ o ‘verdadero’ se ha tambaleado en los últimos años con la llegada de la covid-19, una situación compleja donde la información sesgada procedente de algunos organismos oficiales y la publicación de estudios científicos que se contradecían rápidamente los unos a los otros pusieron en jaque este concepto.

La influencia del idioma y la cultura

Como se trata de una iniciativa internacional, que abordan más de media docena de países, cada una de ellas trabajará en base a distintas lenguas (se espera que un par por país). No obstante, el responsable de HYBRIDS cree que no habrá diferencias significativas en este sentido y que se abordarán cuestiones generales.

Dado el actual momento geopolítico también pueden producirse sesgos relacionados con la veracidad, según las informaciones o datos estructurados provengan de bloques como EE UU, Rusia o China, por ejemplo. “Para mi esa cuestión las tiene que decidir el investigador de cada subproyecto, que deberá considerar lo que tiene más veracidad y lo que no”, sostiene el investigador.

“Si nos referimos a fact checking, hay tres cosas que se deben tener en cuenta. Un primer proceso, como decíamos antes, es identificar si a partir de muchos textos algo es factual u opinativo”. Después, agrega, “necesitamos tener fuentes fiables, las cuales ofrezcan hechos que sean veraces y ahí tendrá que haber especialistas o usarse bases de datos o recursos que la Unión Europea considere fiable, aunque es cierto que ahí hay un grado de subjetividad enorme”.

Por último, el tercer proceso “sería comparar los hechos identificados en los documentos que se están procesando con esas bases de datos o esos recursos donde están los hechos considerados veraces. La clave estaría en los perfiles que trabajen en comunicación o fact checkers, que dictaminen cuáles son los recursos informativos más fiables. Sin embargo, seguimos en el mundo de la subjetividad”, señala.

Otro desafío en la identificación de la desinformación es el uso de algo tan característico en el lenguaje, como es el sarcasmo o la ironía

En su opinión, otro desafío en la identificación de la desinformación en sus diferentes manifestaciones y de actitudes contrarias a las prácticas democráticas es el uso de algo tan característico en el lenguaje –y más en determinadas culturas– como es el sarcasmo o la ironía, algo que se escapa generalmente a sistemas automatizados como los que utilizan las redes sociales para censurar ciertos comentarios o publicaciones.

En este sentido, el proyecto no ha centrado el foco en este aspecto. “Es donde más falla la inteligencia artificial en sus métodos actuales. Está claro que los subproyectos van a tener que tratar estas cosas como algo tangencial, pero ninguno de ellos aborda esto en exclusiva”, revela.

La amenaza de ChatGPT

Cuando HYBRIDS se puso en marcha hace unos meses, ChatGPT, de OpenAI, aun no se había puesto a disposición del público general y la inteligencia artificial generativa no había eclosionado aún. Gamallo reconoce que, en parte, esta innovación les ha hecho replantearse sus investigaciones, ya que “no estaba previsto cuando lo redactamos”.

“En nuestro caso, para este proyecto en concreto ChatGPT supone más bien una amenaza que una ayuda. Es probable que este y otros modelos similares se utilicen para difundir fake news”. Por lo tanto, subraya, “va a haber desinformación difundida por humanos y otra por máquinas. Esta última ya la hay, pero no con tanta ‘inteligencia’. Identificar noticias falsas distribuida por bots hiperinteligentes va a ser uno de los desafíos”.

Para nuestro proyecto, ChatGPT supone más una amenaza que una ayuda. Identificar noticias falsas distribuida por bots hiperinteligentes va a ser complejo

Pablo Gamallo

El investigador, no obstante, matiza que “otra cosa es la tecnología que hay detrás, los grandes modelos de lengua”. Afirma que esos sí pueden resultar un apoyo para su labor, ya que los van a utilizar para construir los sistemas de detección de desinformación.

Gamalllo menciona como hasta el momento se usaba IA para manipular a los usuarios en las redes sociales en eventos como elecciones, con “métodos algo rudimentarios, a través del bombardeo a ciertos perfiles muy concretos con memes o con información susceptible de cambiar la opinión de ese grupo”.

Señala que “así era como funcionaba antes, pero con estos chats con mucha más capacidad se podrán hacer cosas mejores desde el punto de vista de la desinformación. Ahora estará al alcance de cualquiera tener un Cambridge Analytica en casa”.

HYBRIDS es una iniciativa que acaba de arrancar y que concluirá en 2026. El objetivo es que las innovaciones resultantes se distribuyan como software y recursos libres. “Eso no impide que surja alguna spin off que pueda comercializar”, concluye el investigador.